Computer/Machine learning models

Updated: 2024. 2. 20. 11:06

hwaya.

LSTM(Long Short-Term Memory)과 GRU(Gated Recurrent Unit)의 특징 비교

반응형

LSTM(Long Short-Term Memory)과 GRU(Gated Recurrent Unit)는 둘 다 순환 신경망(RNN)의 변형으로, 시퀀스 데이터(예: 시계열 데이터, 텍스트 등)를 처리하는 데 사용됩니다. 두 구조 모두 기본 RNN의 단점인 장기 의존성 문제를 해결하기 위해 고안되었으나, 그들의 내부 구조와 작동 방식에서 차이가 있습니다.

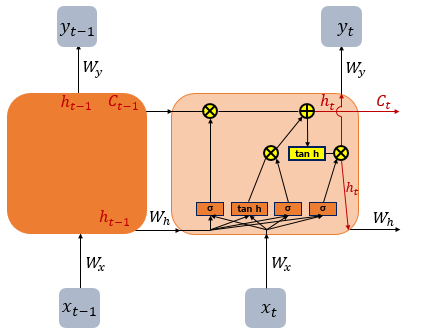

LSTM의 특징

- 게이트: LSTM은 셀 상태를 조절하기 위해 세 개의 게이트(입력 게이트, 출력 게이트, 망각 게이트)를 사용합니다. 이 게이트들은 네트워크가 장기간에 걸친 의존성을 학습할 수 있도록 돕습니다.

- 셀 상태: LSTM은 셀 상태라는 추가적인 정보 흐름을 가지고 있으며, 이는 네트워크를 통해 정보를 장기간에 걸쳐 전달하는 데 도움을 줍니다.

- 매개변수의 수: LSTM은 GRU에 비해 더 많은 매개변수를 가지고 있으며, 이는 더 복잡한 모델을 의미합니다.

- 망각 게이트 (Forget Gate):

- 공식:

f_t = σ(W_f · [h_(t-1), x_t] + b_f) - 역할: 이전 셀 상태

c_(t-1)에서 어떤 정보를 버릴지 결정합니다. 여기서 σ는 시그모이드 함수,W_f와b_f는 학습 가능한 가중치와 편향입니다.

- 공식:

- 입력 게이트 (Input Gate):

- 공식:

i_t = σ(W_i · [h_(t-1), x_t] + b_i),C~_t = tanh(W_C · [h_(t-1), x_t] + b_C) - 역할: 새로운 셀 상태

C~_t를 생성하고, 이 중 어느 부분을 현재 셀 상태에 추가할지 결정합니다.

- 공식:

- 셀 상태 업데이트:

- 공식:

c_t = f_t * c_(t-1) + i_t * C~_t - 역할: 이전 셀 상태를 업데이트하여 현재 셀 상태를 생성합니다.

- 공식:

- 출력 게이트 (Output Gate):

- 공식:

o_t = σ(W_o · [h_(t-1), x_t] + b_o),h_t = o_t * tanh(c_t) - 역할: 셀 상태에 기반해 다음 은닉 상태를 계산합니다.

- 공식:

GRU의 특징

- 간소화된 구조: GRU는 LSTM보다 간소화된 구조를 가지고 있으며, 두 개의 게이트(업데이트 게이트와 리셋 게이트)만을 사용합니다.

- 셀 상태 없음: GRU는 LSTM의 셀 상태를 사용하지 않으며, 오직 은닉 상태만을 가집니다. 이는 모델이 더 간단해지고 계산 효율성이 향상됩니다.

- 매개변수의 수: GRU는 LSTM보다 적은 수의 매개변수를 가지고 있어, 더 작고 빠른 모델을 만들 수 있습니다.

- 리셋 게이트 (Reset Gate):

- 공식:

r_t = σ(W_r · [h_(t-1), x_t] + b_r) - 역할: 이전 은닉 상태

h_(t-1)을 얼마나 고려할지 결정합니다.

- 공식:

- 업데이트 게이트 (Update Gate):

- 공식:

z_t = σ(W_z · [h_(t-1), x_t] + b_z) - 역할: 이전 은닉 상태를 얼마나 유지할지와 새로운 후보 은닉 상태를 얼마나 사용할지 결정합니다.

- 공식:

- 은닉 상태 업데이트:

- 공식:

h~_t = tanh(W · [r_t * h_(t-1), x_t] + b),h_t = (1 - z_t) * h_(t-1) + z_t * h~_t - 역할: 새로운 은닉 상태를 계산합니다. 리셋 게이트는 이전 정보를 얼마나 유지할지 조절하고, 업데이트 게이트는 새로운 정보를 얼마나 받아들일지 조절합니다.

- 공식:

LSTM과 GRU의 선택

- 데이터의 복잡성과 길이: 복잡하거나 매우 긴 시퀀스 데이터의 경우, LSTM이 더 적합할 수 있습니다. LSTM의 추가적인 구조가 더 복잡한 패턴을 학습하는 데 도움이 될 수 있습니다.

- 학습 시간과 계산 자원: GRU는 더 적은 매개변수를 가지므로, 학습 시간이 더 짧고 계산 자원이 덜 필요할 수 있습니다. 따라서 더 간단한 시퀀스 데이터나 제한된 계산 자원을 가진 경우에 적합할 수 있습니다.

결론적으로, LSTM과 GRU 간의 선택은 특정 작업의 요구사항, 사용 가능한 데이터의 특성, 그리고 사용 가능한 계산 자원에 따라 달라질 수 있습니다. 때로는 실험을 통해 두 구조 중 어느 것이 특정 작업에 더 적합한지 결정하는 것이 필요할 수 있습니다.

반응형

'Computer > Machine learning models' 카테고리의 다른 글

| 데이터 어노테이션(Data Annotation) (0) | 2024.07.10 |

|---|---|

| RNN에서 사용되는 'input_shape' 알아보자 (0) | 2024.02.20 |

| recurrent_activation (0) | 2024.02.14 |

| Epochs 와 Batch Size (0) | 2024.02.13 |

| 데이터 분할 : train_test_split (1) | 2024.02.13 |